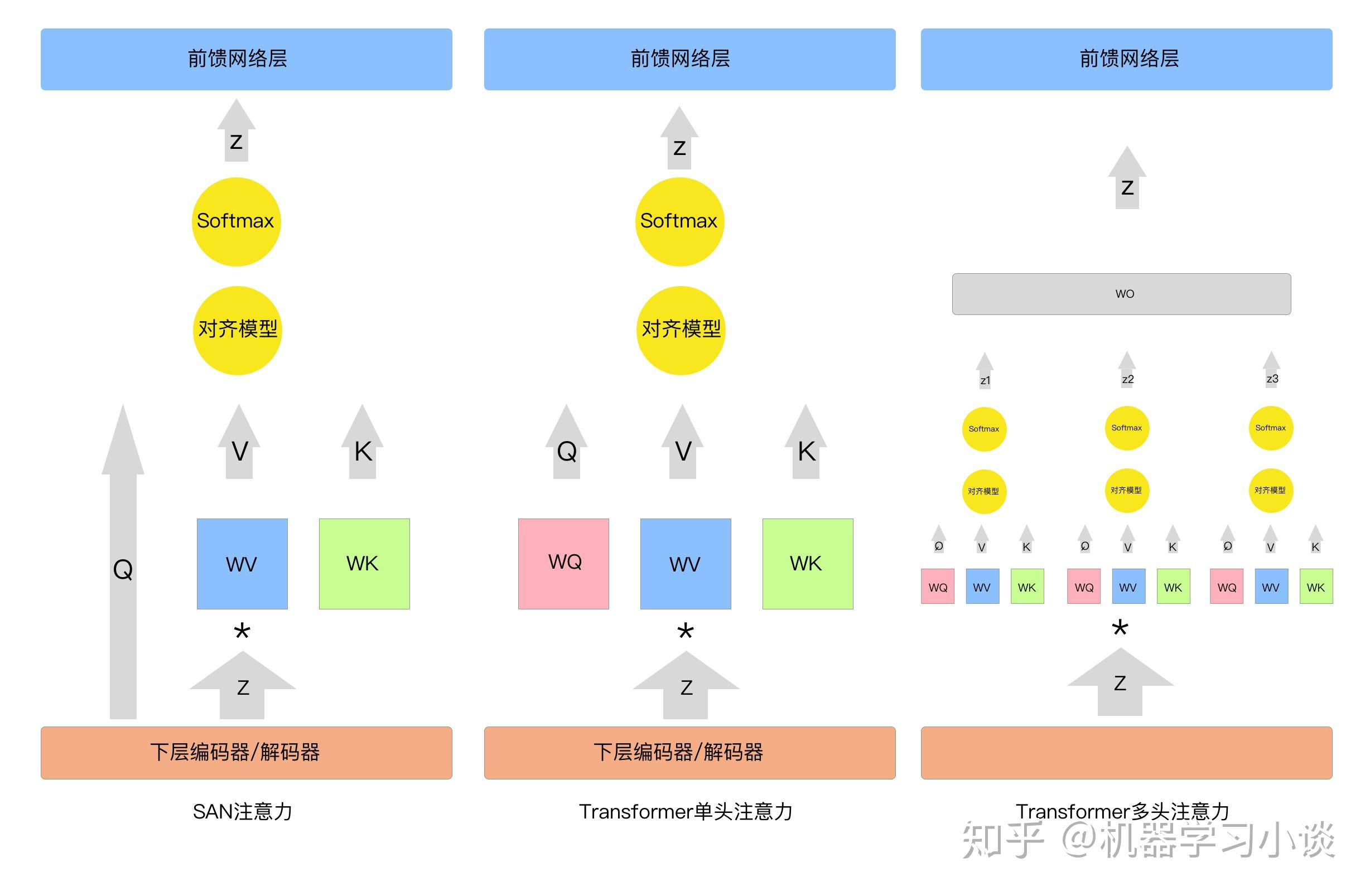

Self-Attention

Self-Attention

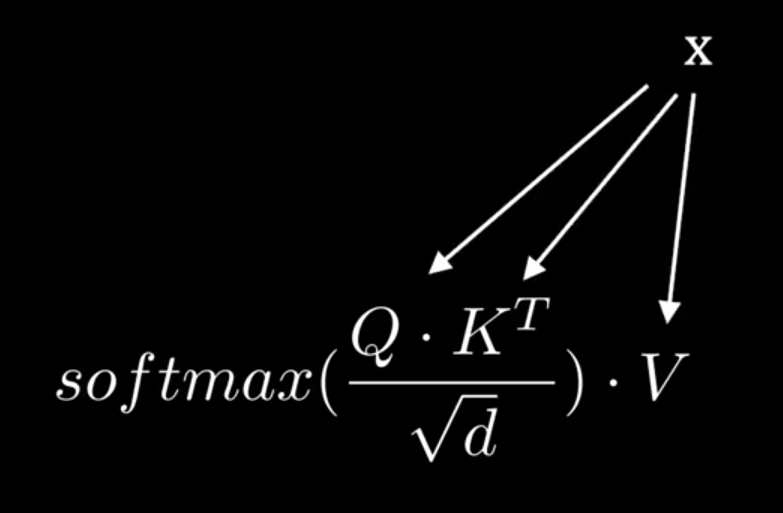

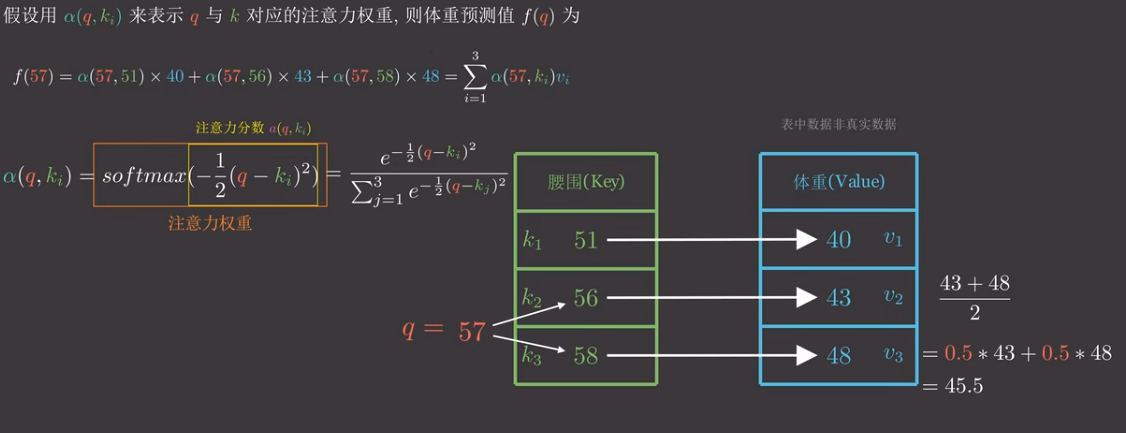

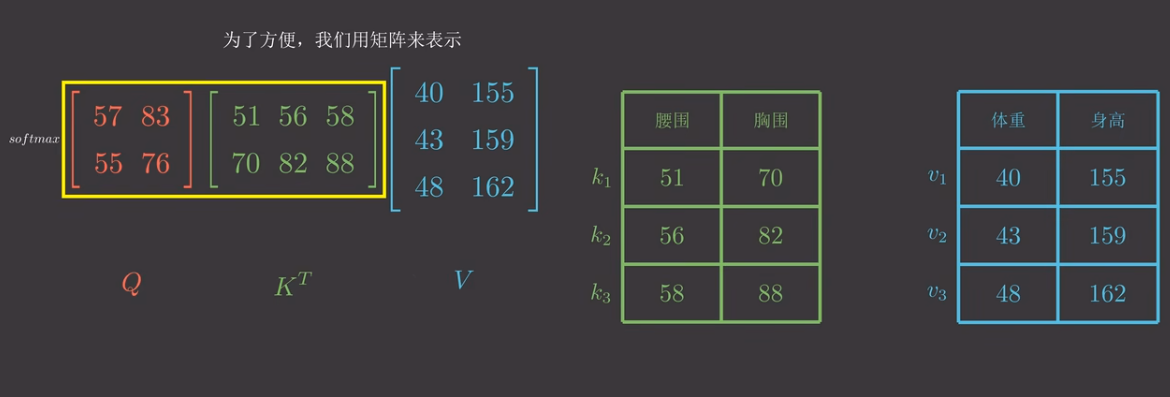

以腰围和身高举例

腰围是K,身高是V,有对应关系。这时我希望用Q对合适的K进行查询,Q也是腰围,我希望得到合适的V,一般情况下我需要计算各个腰围K的权重并与V相乘,得到最终结果 若KQV矩阵是自身,则是自注意力机制。

Introduction

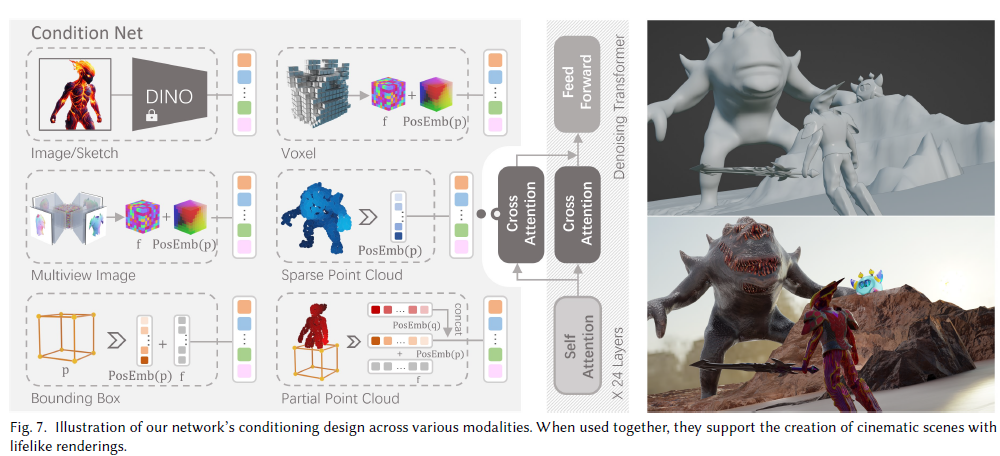

Self Attention

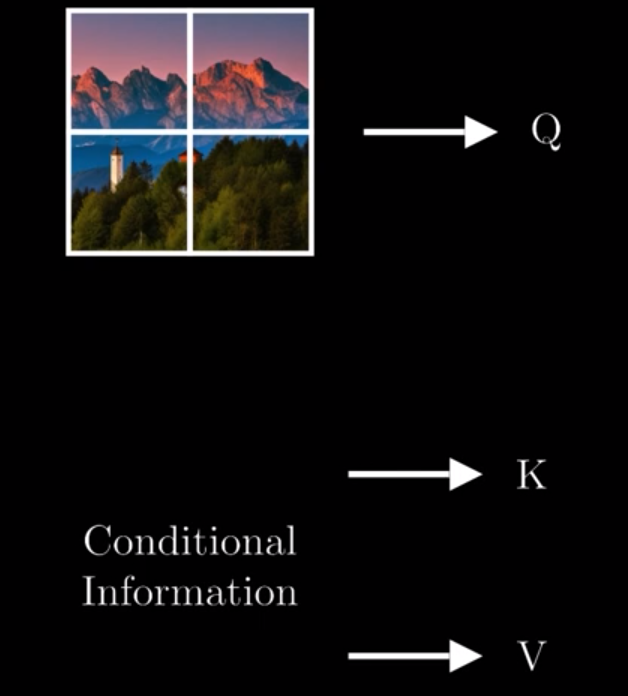

Cross Attention

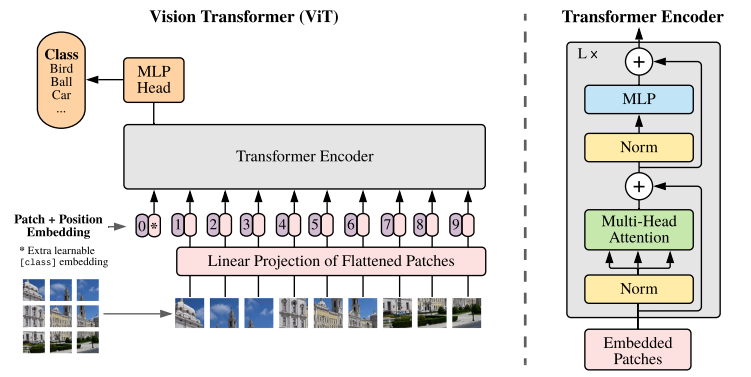

ViT(Vision Transformer)解析

Reference

-

[注意力机制的本质 Self-Attention Transformer QKV矩阵 - BiliBili](https://www.bilibili.com/video/BV1dt4y1J7ov/?spm_id_from=333.337.search-card.all.click&vd_source=fd373f40f4a1d2e059be533c5b77797f) - Cross Attention _ Method Explanation _ Math Explained - BiliBili

- Attention机制详解(二)——Self-Attention与Transformer - 川陀学者的文章 - 知乎

- 从ReLU到GELU,一文概览神经网络的激活函数 - 机器之心的文章 - 知乎

- Transformer中使用GELU

- ViT(Vision Transformer)解析 - 德怀特的文章 - 知乎

- 图片Transformer

- VAE、GAN 这种生成模型和 transformer 有什么区别? - 知乎用户的回答 - 知乎

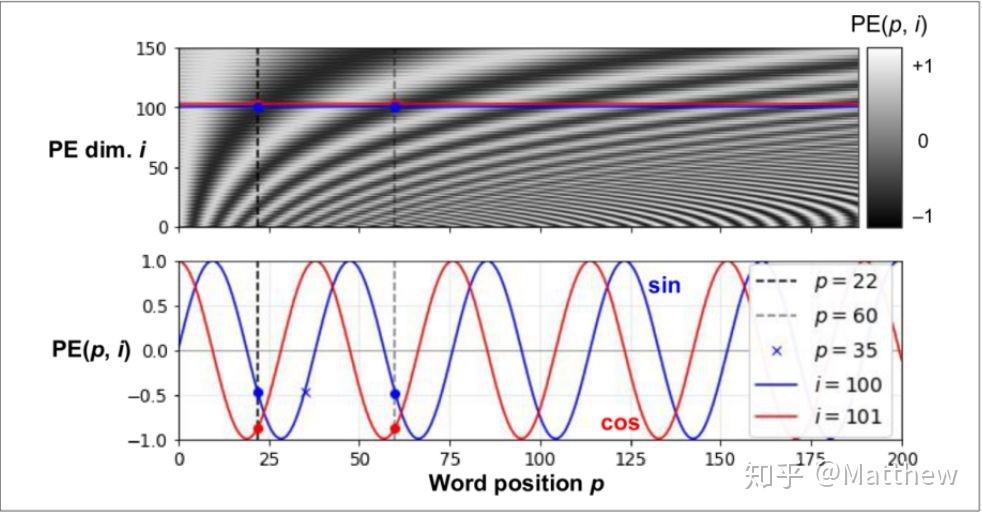

- 一文读懂Transformer模型的位置编码 - 眺望远方的龙的文章 - 知乎

- 位置编码

- 自注意力与位置编码 - 机器学习小谈的文章 - 知乎

- 【时间序列】Transformer for TimeSeries时序预测算法详解 - VoidOc的文章 - 知乎

- 第二章:Transformer 模型

- The Illustrated Transformer

- 英文原文

- 详解Transformer (Attention Is All You Need) - 大师兄的文章 - 知乎